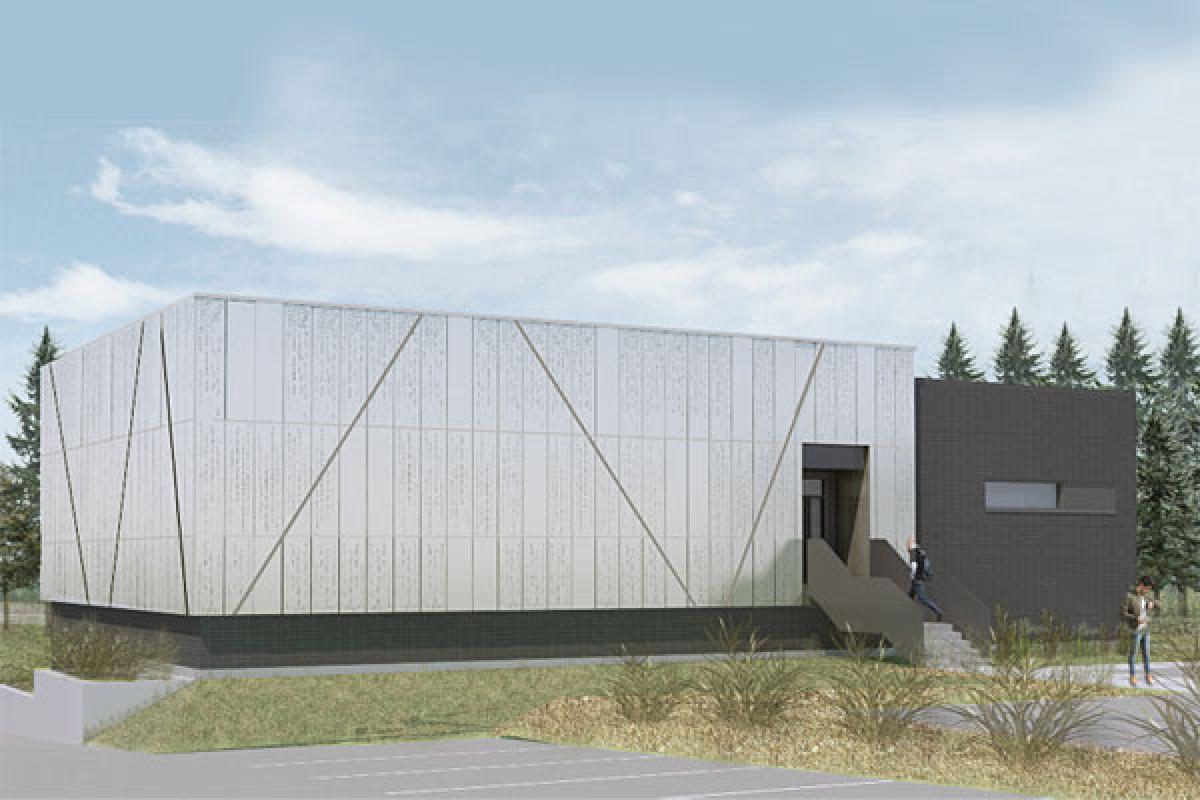

Le futur Centre de valorisation des données de l’Université Laval fera le pont entre la boite noire, opaque et étanche, et l’innovation technologique.

L’Université Laval a donné le coup d’envoi de la construction de son futur Centre de valorisation des données (CVD) en avril 2018. Ce pavillon, d’une superficie de 1 224 mètres carrés (m2), aura pour mission de colliger, de traiter et de valoriser des données massives en soutien aux activités de recherche de l’université et de ses partenaires publics et parapublics.

À première vue, rien de nouveau sous le soleil. Sinon que le bâtiment monolithique, évalué à 21,5 millions de dollars, sera un modèle d’efficacité énergétique. Non seulement il s’autosuffira en chauffage durant la saison froide, mais l’excédent de chaleur dégagé par les équipements informatiques sera récupéré pour chauffer d’autres pavillons. Il permettra de plus d’assurer l’alimentation d’urgence de trois autres pavillons, dont le Centre de calcul haute performance.

Design équilibré

On s’en doute, de telles installations dégagent énormément de chaleur. Elles doivent donc être refroidies pour éviter toute panne. Toutefois, si l’ingénierie thermique joue un rôle clé dans la conception, le design architectural n’a pas été négligé pour autant. Loin de là, même. Pour faire de ce bâtiment un exemple de rendement énergétique, les concepteurs de DAD Architecture/Design se sont d’abord attaqués à la réduction des gains thermiques en profitant du dénivelé du terrain pour l’enfouir en partie dans le sol.

Ils ont également pris le pari de le concevoir en deux volumes. Le volume principal, qui forme la base (l’énergie) du CVD, sera relié par un tunnel au campus. Regroupant les locaux techniques, mécaniques et électriques, ce volume de 850 m2 sera sobrement habillé de maçonnerie noire. Quant au second volume, il surmontera le premier et abritera la salle des serveurs (le cerveau). D’une superficie de 350 m2, il sera revêtu d’aluminium perforé gris foncé qui conférera à l’ensemble un caractère industriel.

Fait à noter, une seule fenêtre éclairera les lieux. « Personne n’y travaillera, toutes les activités seront pilotées à distance, souligne René Lacroix, vice-recteur adjoint à l’administration de l’Université Laval. Sans compter que c’est un environnement très bruyant, avec une ventilation en continu, et il y fait très chaud. On y va donc par nécessité. Il s’agit aussi d’une question de sécurité : un centre de données est un lieu névralgique, où se trouvent stockées des quantités énormes d’information. Mieux vaut ne pas trop dévoiler sa mission. »

Mécanique adaptée

Si le CVD sera un bâtiment plutôt standard, avec une structure d’acier sur dalle de béton et une enveloppe conventionnelle, il en va autrement sur le plan électromécanique. Sa consommation électrique sera en effet très importante. Le « cerveau » contiendra jusqu’à 48 baies de stockage de 48 serveurs chacune qui, à pleine capacité, consommeront jusqu’à 600 kilowatts (kW). À cela s’ajouteront 200 kW pour la puissance mécanique nécessaire au refroidissement des serveurs, et 50 kW pour les charges de base.

« Les machines consomment de l’énergie et cette énergie est transformée en chaleur, mentionne René Lacroix. Il fallait donc trouver des solutions pour refroidir les équipements et éviter les pannes. » Pour assurer la fiabilité des installations, les serveurs ont d’abord été configurés selon le procédé dit de virtualisation. Cette configuration permet de mutualiser les capacités des serveurs et, de ce fait, de réduire la puissance requise.

Il fallait également maintenir une température optimale et prévenir les surchauffes. C’est pourquoi les professionnels de SNC-Lavalin ont spécifié un système de ventilation composé de six ventilateurs axiaux à entrainement direct et à débit variable fonctionnant à basse vitesse. La vitesse est modulée pour maintenir un différentiel de pression statique fixe entre les allées froides (devant les serveurs) et les allées chaudes (derrière les serveurs). Ce contrôle a pour effet de réduire la consommation d’énergie des ventilateurs en réglant le débit d’air en fonction des besoins de refroidissement.

Efficacité démontrée

Restait à évacuer la chaleur produite par les équipements. Pour ce faire, la chaleur sera aspirée par l’échangeur d’air et injectée dans le réseau central d’eau réfrigérée du campus, où elle sera reprise pour chauffer d’autres pavillons en hiver. Ceux-ci sont équipés de pompes thermiques eau/eau qui génèrent de l’eau de chauffage à 45 degrés Celsius, tout en produisant de l’eau réfrigérée. L’air refroidi est ensuite retourné au CVD. Ce réseau en boucle continu aura une efficacité globale annuelle de 0,576 kW/tonne.

À cela s’ajouteront trois refroidisseurs à vis d’une capacité de 100 tonnes chacun, couplés à trois refroidisseurs de liquide installés à l’extérieur du bâtiment. « La capacité des systèmes de refroidissement, installés en redondance, est supérieure aux besoins informatiques, note Guillaume Moutier, directeur du Bureau d’architecture de l’Université Laval. La capacité excédentaire pourra être utilisée pour desservir des besoins en eau réfrigérée sur le campus lors de pannes électriques. Parce qu’en cas de panne, tout doit fonctionner quand même. »

Enfin, pour ce qui est des besoins de chauffage du CVD, ils seront essentiellement comblés par les dégagements de chaleur des divers procédés, à savoir les serveurs, les transformateurs et les chauffe-blocs des génératrices.

Pour éviter toute défaillance des systèmes, le Centre de valorisation de données regroupera cinq génératrices. Deux d’entre elles alimenteront un nouveau réseau de distribution électrique d’urgence souterrain à 4,16 kV. Ce réseau comblera les besoins électriques des équipements de secours et de procédés de quatre autres pavillons de l’Université Laval, dont celui du supercalculateur.

Les trois autres fourniront l’électricité nécessaire pour faire fonctionner les UPS (Uninterruptible Power Supply), les serveurs ainsi que les équipements de ventilation et de refroidissement du centre de données lors de pannes électriques.

Cet article est tiré du Supplément thématique – Bâtiment 2018. Pour un accès privilégié à l’ensemble des contenus et avant-projets publiés par Constructo, abonnez-vous !

Ce sujet pique votre curiosité ? Lisez tous les articles du dossier BÂTIMENT 2018 :

- CHUSJ : innover tout en simplifiant la redondance

- Convertir un vieux couvent en centre multifonctionnel

- Aéroport international Jean-Lesage : exemplarité énergétique et haute voltige mécanique

- Quartier MIL : Le complexe des sciences prend forme

- L’ABC du BIM pour les gestionnaires de bâtiments

- Allier génie de combat et génie mécanique

- Un système de toiture renforcé sous vide

![La salle J.-Antonio-Thompson se refait une beauté. Crédit : JS Désilets - Amplifie[.]ca La salle J.-Antonio-Thompson se refait une beauté. Crédit : JS Désilets - Amplifie[.]ca](/sites/default/files/styles/image_grid/public/salle-thompson_projets.jpg?itok=UPWo-8xi)